آیا فقط من اینگونه هستم، یا واژه های «برچسبهای رباتهای متا» و «robots.txt» شبیه همانی است که شوارتزنگر در «ترمیناتور 2» گفته است؟

این یکی از دلایلی است که من شروع به فعالیت در زمینه ی سئو کردم، به نظر می رسید کار آینده نگرانه ای است اما برای تقویت مهارت های من در آن زمان بسیار کاربردی بود.

امیدواریم این مقاله تنظیم برچسب های متا روباتها و فایلهای robots.txt را کمی تسهیل کند. با ما همراه باشید.

برچسب های متا روبات ها در مقابل Robots.txt

قبل از اینکه بخواهیم اصول متا رباتها و فایلهای robots.txt را بررسی کنیم، باید بدانیم هیچ طرفی برای استفاده در سئو بهتر از دیگری نیست.

فایل های Robots.txt سرتاسر سایت را به جستجوگرها آموزش می دهند.

این در حالی است که برچسب های متا ربات ها وارد صفحه خاصی می شوند.

من ترجیح می دهم از برچسب های متا ربات ها در مواردی استفاده کنم که سایر متخصصان برای آن از فایل robots.txt استفاده کنند.

هیچ درست و غلطی وجود ندارد. این یک اولویت شخصی بر اساس تجربه شما است.

Robots.txt چیست؟

یک فایل robots.txt به جستجوگر ها می گوید که چه چیزی باید بررسی شود.

این کار بخشی از پروتکل حذف روبات ها (REP) است.

Googlebot نمونه ای از یک جستجوگر (خزنده) است.

Google از Googlebot برای پویش در وبسایتها و ثبت اطلاعات در آن سایت استفاده میکند تا نحوه رتبهبندی سایت در نتایج جستجوی Google را درک نماید.

می توانید فایل robots.txt هر سایتی را با افزودن /robots.txt بعد از آدرس وب همان سایت، مانند زیر پیدا کنید:

www.mywebsite.com/robots.txt

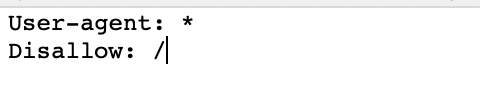

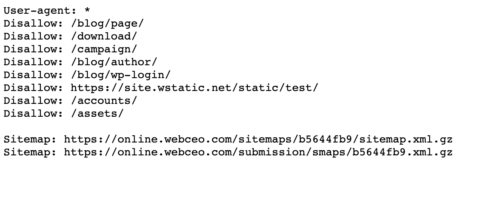

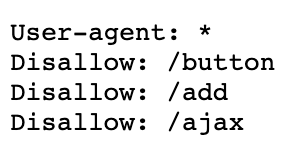

در اینجا فایل robots.txt یک مورد جدید و اساسی به نظر می رسد:

ستاره * بعد از user-agent به جستجوگر ها می گوید که فایل robots.txt متعلق به تمام ربات هایی است که به سایت می آیند.

علامت اسلش / بعد از “Disallow” به ربات می گوید که به هیچ صفحه ای در سایت وارد نشود.

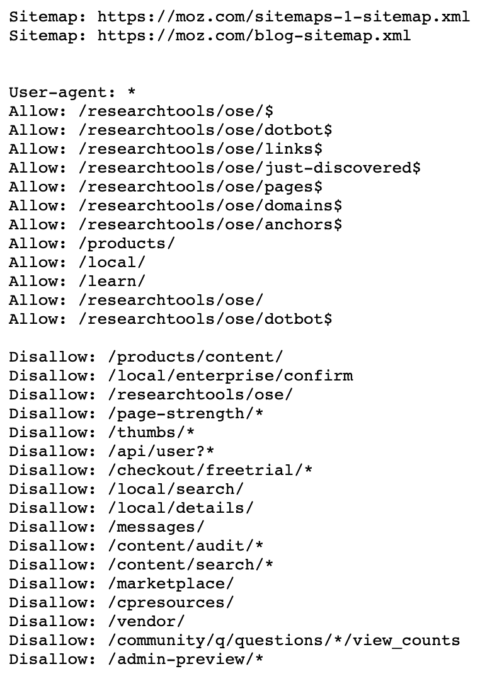

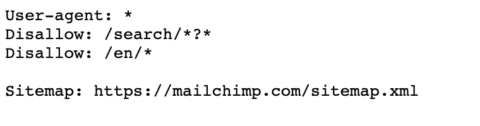

در اینجا نمونه ای از فایل robots.txt Moz آمده است.

همانگونه که مشاهده می کنید، آنها به جستجوگر ها می گویند که چه صفحاتی را با استفاده از عوامل کاربری و دستورالعمل ها بررسی کنند. در ادامه به این موضوع نیز می پردازم.

چرا Robots.txt مهم است؟

پس از انتقال وب سایت یا راه اندازی یک وب سایت جدید، کاربران زیادی به من مراجعه می کنند و از من می پرسند: چرا سایت من پس از ماه ها کار، رتبه بندی نمی شود؟

به جرات می توانم بگویم 60٪ دلیل این است که فایل robots.txt به درستی به روزرسانی نمی شود.

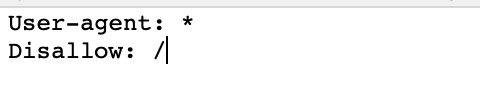

به این معنی که فایل robots.txt شما شبیه چنین حالتی است:

این کار باعث مسدود شدن تمام جستجوگر هایی می شود را که از سایت شما بازدید می کنند.

دلیل دیگری که برای robots.txt مهم است این است که گوگل چیزی به نام حجم جستجو دارد.

گوگل در این باره می گوید:

"Googlebot برای این طراحی شده است که یک تابع خوب در وب باشد. جستجو اولویت اصلی آن است، و این در حالی است که باید از عدم کاهش تجربه بازدید کاربران از سایت اطمینان حاصل نماید. ما این را "محدودیت سرعت جستجو" می نامیم، که حداکثر نرخ ورود و خروج را برای یک سایت معین محدود می کند.

به بیان ساده، این تعداد اتصالات موازی همزمان Googlebot را نشان می دهد که ممکن است برای جستجو در سایت استفاده کند، و همچنین مدت زمانی را نشان می دهد که باید بین ورود و خروج ها منتظر بماند."

بنابراین، اگر سایت بزرگی با صفحات با کیفیت پایین دارید که نمیخواهید گوگل آنها را پیدا کند، میتوانید به Google بگویید آنها را در فایل robots.txt خود به صورت «غیرمجاز» در آورد.

با این کار حجم جستجوی شما آزاد میشود تا تنها صفحات باکیفیتی را که میخواهید Google شما را در آنها رتبهبندی کند، پیدا نماید.

هنوز هیچ قانون سفت و سخت و سریعی برای فایلهای robots.txt وجود ندارد.

گوگل در (تیر ماه 1398) ژوئیه 2019 پیشنهادی را برای شروع اجرای استانداردهای خاص اعلام کرد، اما در حال حاضر، من دنباله روی بهترین روش هایی هستم که در چند سال گذشته انجام داده ام.

مبانی Robots.txt

نحوه استفاده از Robots.txt

استفاده از robots.txt برای موفقیت در سئو بسیار حیاتی است.

اما، درک نکردن نحوه عملکرد آن میتواند باعث شود که در مورد عدم رتبهبندی مناسب، سردرگم شوید.

موتورهای جستجو سایت شما را بر اساس آنچه در فایل robots.txt به آنها می گویید با استفاده از دستورات و عبارات پیدا کرده و فهرست بندی می کنند.

در زیر دستورالعمل های رایجی از robots.txt وجود دارد که باید بدانید:

User-agent: * — این اولین خط در فایل robots.txt شما است که به جستجوگر ها قوانین آنچه را که می خواهید آنها در سایت شما پیدا کنند توضیح می دهد. علامت ستاره به همه جستجوگرها این موضوع را اطلاع می دهد.

User-agent: Googlebot – این عامل تنها آنچه را که می خواهید جستجوگر Google پیدا کند بیان می نماید.

Disallow: / - این عامل به همه جستجوگرها میگوید که کل سایت شما را جستجو نکنند.

Disallow: - به همه جستجوگرها میگوید که کل سایت شما را واکاوی کنند.

Disallow: /staging/ - به همه جستجوگرها میگوید که مرحلهبندی سایت شما را نادیده بگیرند.

Disallow: /ebooks/* .pdf - به جستجوگرها میگوید که تمام قالبهای PDF شما را که ممکن است باعث مشکلات محتوای تکراری شود نادیده بگیرند.

User-agent: Googlebot

Disallow: /images/ - به جستجوگر Googlebot می گوید که تمام تصاویر موجود در سایت شما را نادیده بگیرد.

* - به عنوان یک علامت عام دیده می شود که هر دنباله ای از کاراکترها را نشان می دهد.

$ - برای مطابقت با انتهای URL استفاده می شود.

برای ایجاد فایل robots.txt، از Yoast for WordPress استفاده می کنم که در حال حاضر با سایر ویژگی های SEO در سایت های من ادغام شده است.

اما، قبل از شروع به ایجاد فایل robots.txt، در اینجا چند نکته اساسی وجود دارد که باید به خاطر بسپارید:

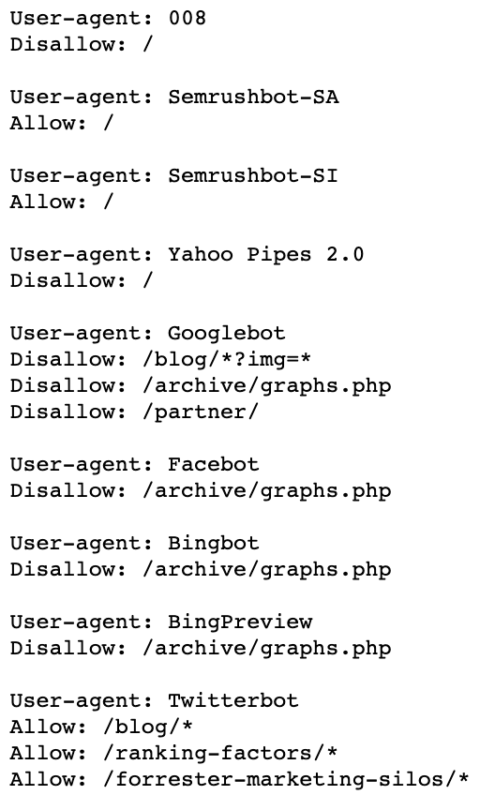

- robots.txt خود را به طور صحیح قالب بندی کنید. SEMrush نمونه ای عالی از نحوه فرمت صحیح robots.txt انجام می دهد. می بینید که این ساختار از این الگو پیروی می کند: User-agent → Disallow → Allow → Host → Sitemap. این به پوینده های موتور جستجو اجازه میدهد تا به دستهها و صفحات وب به ترتیب مناسب دسترسی پیدا کنند.

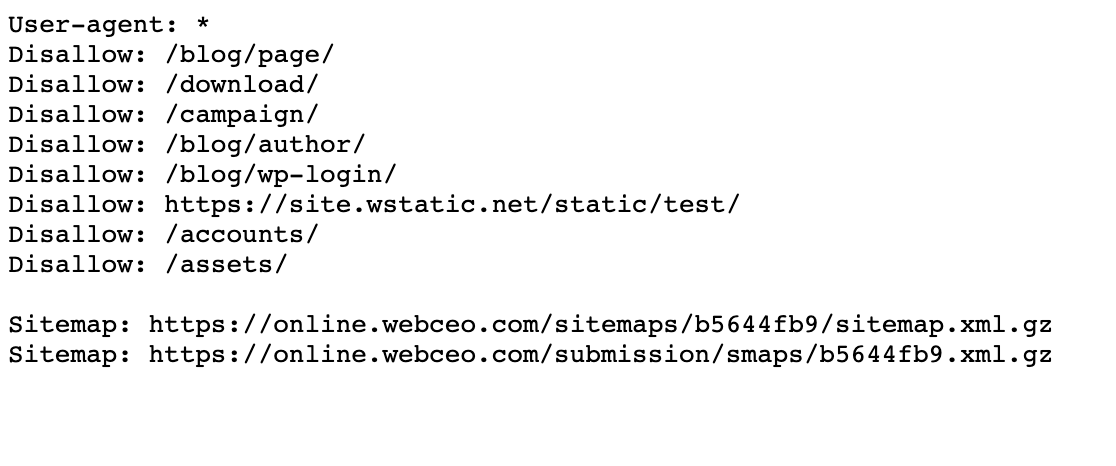

- اطمینان حاصل کنید که هر نشانی اینترنتی که میخواهید «Allow:» یا «Disallow:» را انتخاب کنید، در یک خط جداگانه مانند Best Buy در زیر قرار میگیرد و با فاصله از هم جدا نشده باشند.

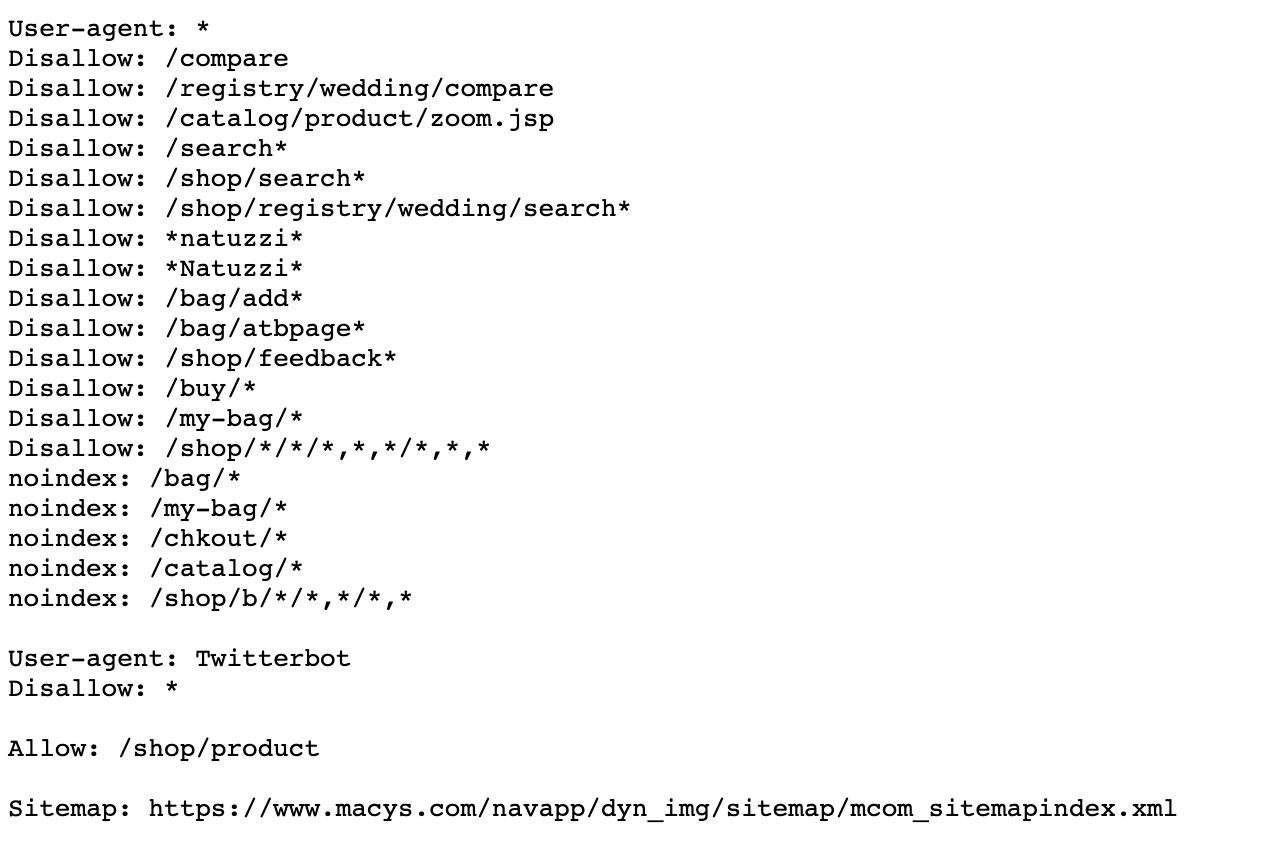

- همیشه از حروف کوچک برای نام گذاری robots.txt خود مانند WebCEO استفاده کنید.

- از هیچ کاراکتر خاصی به جز * و $ استفاده نکنید. کاراکترهای دیگر شناخته نمی شوند.

- فایل های robots.txt جداگانه برای زیر دامنه های مختلف ایجاد کنید. برای مثال، «hubspot.com» و «blog.hubspot.com» دارای فایلهای جداگانه ای بوده و هر دو فایلهای robots.txt متفاوتی دارند.

- از # برای گذاشتن نظرات در فایل robots.txt خود استفاده کنید. جستجوگر ها به نظراتی مانند " I did here with this robots.txt file. " به خطوط با کاراکتر # توجهی ندارند.

- اگر صفحهای در فایلهای robots.txt غیرمجاز باشد، لینک معادل از آن عبور نخواهد کرد.

- هرگز از robots.txt برای محافظت یا مسدود کردن داده های حساس استفاده نکنید.

چه چیزی را با Robots.txt پنهان کنیم

فایلهای robots.txt اغلب برای حذف دایرکتوریها، دستهها یا صفحات خاصی از SERP بکار می روند.

می توانید با استفاده از دستورالعمل " disallow" آن را حذف کنید.

در اینجا چند صفحه رایج وجود دارد که با استفاده از فایل robots.txt پنهان می کنیم:

- صفحات با محتوای تکراری (اغلب محتوای مناسب چاپگر)

- صفحات مربوط به صفحه بندی

- صفحات محصول و خدمات پویا

- صفحات حساب کاربری

- صفحات مدیریت

- سبد خرید

- چت ها

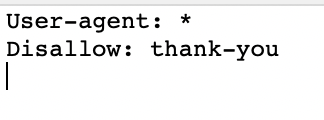

- صفحات تقدیر و تشکر

این برای سایت هایی با محتوای تجارت الکترونیک با استفاده از پارامترهایی مانند Macy بسیار مفید خواهد بود.

و در اینجا می توانید ببینید که چگونه صفحه تشکر را غیر مجاز (disallow) کرده ام.

لازم به ذکر است که همه جستجوگر ها فایل robots.txt شما را دنبال نمی کنند.

ربات های مخرب می توانند فایل robots.txt شما را به طور کامل نادیده بگیرند، بنابراین باید اطمینان حاصل کنید که داده های حساس را در صفحات مسدود شده نگهداری نمی کنید.

اشتباهات رایج Robots.txt

پس از مدیریت فایل های robots.txt برای بیش از 10 سال، در اینجا چند خطای رایج وجود دارد که می بینم:

اشتباه شماره 1: نام فایل حاوی حروف بزرگ است

تنها نام ممکن و مناسب، robots.txt است، نه Robots.txt یا ROBOTS.TXT.

وقتی صحبت از سئو به میان می آید، همیشه از حروف کوچک استفاده کنید.

اشتباه شماره 2: قرار ندادن فایل Robots.Txt در دایرکتوری اصلی

اگر می خواهید فایل robots.txt شما پیدا شود، باید آن را در دایرکتوری اصلی سایت خود قرار دهید.

اشتباه

www.mysite.com/tshirts/robots.txt

صحیح

www.mysite.com/robots.txt

اشتباه شماره 3: User-agent با فرمت نادرست

اشتباه

disallow: Googlebot

صحیح

User-agent: Googlebot

disallow:/

اشتباه شماره 4: ذکر چندین کاتالوگ در یک خط " disallow".

اشتباه

Disallow: /css/ /cgi-bin/ /images/

درست

Disallow: /css/

Disallow: /cgi-bin/

Disallow: /images/

اشتباه شماره 5: خط خالی در « User-Agent»

اشتباه

User-agent:

Disallow:

درست

User-agent: *

اشتباه شماره 6: انعکاس وب سایت ها و آدرس اینترنتی در دستورالعمل میزبان

هنگام ذکر دستورالعمل های "میزبان" مراقب باشید تا موتورهای جستجو منظور شما را به درستی درک کنند:

اشتباه

User-agent: Googlebot

Disallow: /cgi-bin

درست

User-agent: Googlebot

Disallow: /cgi-bin

میزبان: www.site.com

اگر سایت شما دارای https است، گزینه صحیح برابر است با:

User-agent: Googlebot

Disallow: /cgi-bin

میزبان: https://www.site.com

اشتباه شماره 7: فهرست کردن همه فایل های داخل دایرکتوری

اشتباه

User-agent: *

Disallow: /pajamas/flannel.html

Disallow: /pajamas/corduroy.html

Disallow: /pajamas/cashmere.html

صحیح:

User-agent: *

Disallow: /pajamas/

Disallow: /shirts/

اشتباه شماره 8: بدون دستورالعمل غیر مجاز

لازم است که هدف از دستورالعملهای غیر مجاز توسط رباتهای موتور جستجو درک شوند.

اشتباه:

User-agent: Googlebot

Host: www.mysite.com

صحیح:

User-agent: Googlebot

Disallow:

Host: www.mysite.com

اشتباه شماره 9: مسدود کردن کل سایت شما

اشتباه

User-agent: Googlebot

Disallow: /

صحیح:

User-agent: Googlebot

Disallow:

اشتباه شماره 10: استفاده از دستورالعمل های مختلف در بخش *

اشتباه

User-agent: *

Disallow: /css/

Host: www.example.com

صحیح:

User-agent: *

Disallow: /css/

اشتباه شماره 11: هدر HTTP اشتباه است

اشتباه

Content-Type: text/html

درست

Content-Type: text/plain

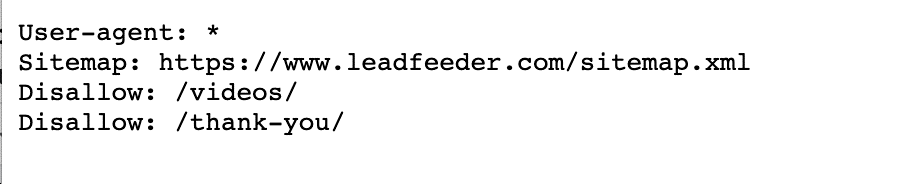

اشتباه شماره 12: بدون نقشه سایت

همیشه نقشه های سایت خود را در پایین فایل robots.txt قرار دهید.

اشتباه

صحیح

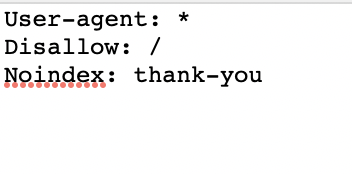

اشتباه شماره 13: استفاده از Noindex

گوگل در سال 1398 (۲۰۱۹) اعلام کرد که از این تاریخ به بعد، دستورالعمل noindex مورد استفاده در فایلهای robots.txt را تایید نخواهد کرد.

بنابراین، به جای آن از برچسب های متا روباتی که در ادامه در مورد آنها صحبت خواهم کرد استفاده نمایید.

اشتباه

صحیح:

اشتباه شماره 14: غیر مجاز کردن صفحه در فایل Robots.Txt، که همچنان به آن لینک داده می شود

اگر صفحهای را در فایل robots.txt غیرمجاز کنید، و اگر لینک های داخلی به آن صفحه داشته باشید، Google همچنان آن صفحه را پیدا خواهد کرد.

شما باید آن لینک ها را حذف کنید تا جستجوگر ها به طور کامل جستجوی آن صفحه را متوقف کنند.

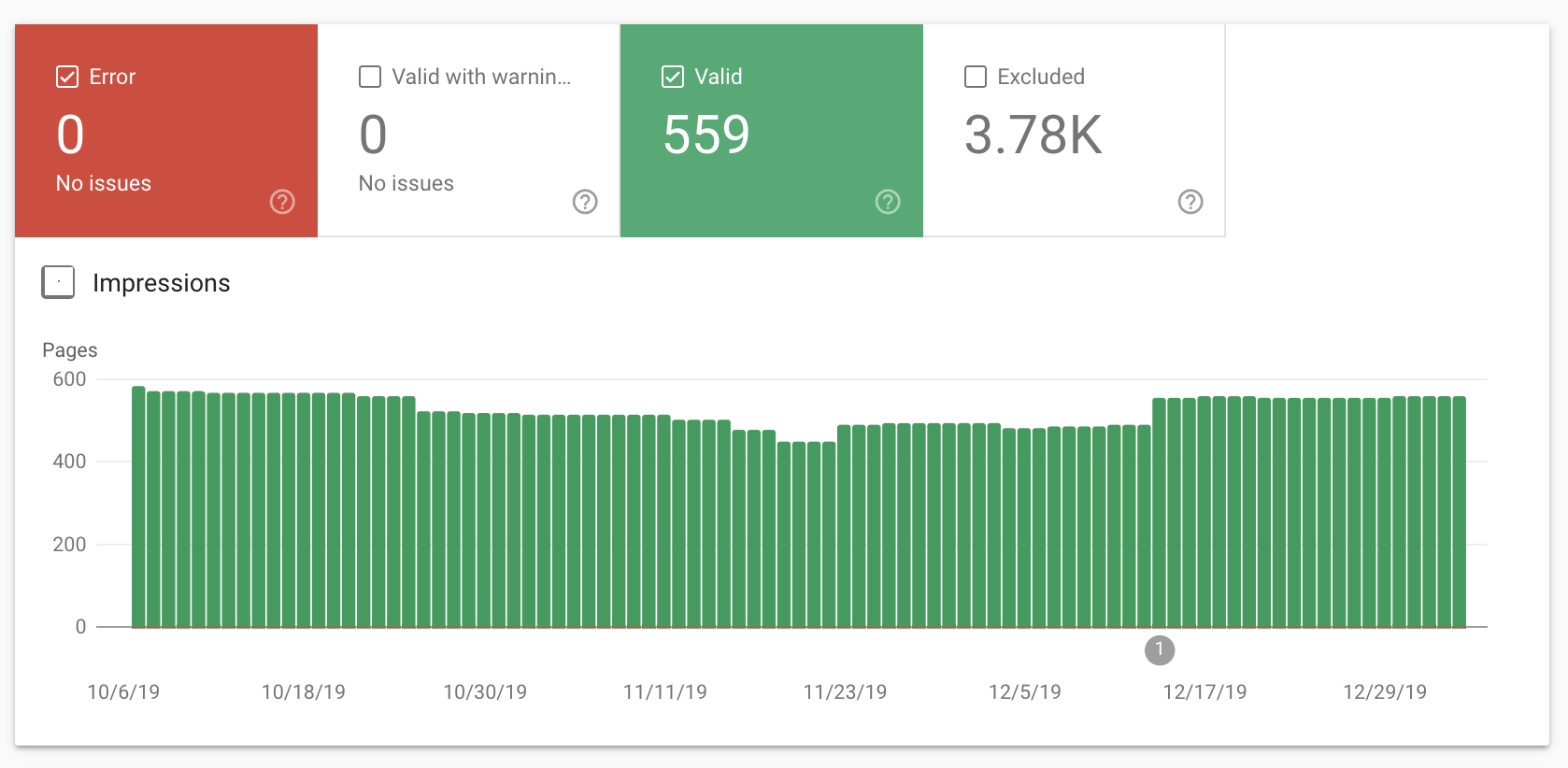

اگر مطمئن نیستید، میتوانید بررسی کنید که کدام صفحات در گزارش پوشش کنسول جستجوی Google شما نمایه شده اند.

باید چیزی شبیه به این را ببینید:

و می توانید از ابزار تست robots.txt گوگل استفاده کنید.

اگر از ابزار تست نسخه ی موبایل گوگل استفاده میکنید، این کار از قوانین شما در فایل robots.txt پیروی نخواهد کرد.

برچسب های متا ربات ها چیست؟

برچسب های متا روبات (که دستورالعملهای متا روباتها نیز نامیده میشوند) قطعههایی از کد HTML هستند که به جستجوگرهای موتور جستجو میگویند تا چگونه صفحات را در وبسایت شما یافته و نمایه کنند.

برچسب های متا روبات ها به بخش < head > یک صفحه وب اضافه می شوند.

به عنوان مثال:

< meta name=”robots” content=”noindex” / >

برچسب های متا روبات ها از دو قسمت تشکیل شده اند.

- اولین قسمت برچسب ، name=''’ است.

در این قسمت عامل کاربر را شناسایی می کنید. به عنوان مثال، "Googlebot."

- قسمت دوم برچسب، content='' است. در اینجا به ربات ها می گویید که می خواهید چه کاری انجام دهند.

انواع برچسب های متا ربات ها

برچسب های متا روبات ها دو نوع برچسب دارند:

- برچسب متا روبات ها

- برچسب ربات های ایکس.

نوع 1: برچسب متا روبات ها

برچسب های متا ربات ها معمولا توسط بازاریابان سئو استفاده می شود.

این برچسب ها به شما امکان میدهد تا به عوامل کاربر (بهعنوان Googlebot) بگویید که کدام مناطق خاص را بررسی کنند.

به عنوان مثال:

< meta name=”googlebot” content=”noindex,nofollow” >

این برچسب متا ربات ها به جستجوگر گوگل، Googlebot، می گوید که صفحه را در موتورهای جستجو نمایه نکند و هیچ لینکی را دنبال ننماید.

بنابراین، این صفحه جزو SERP ها نخواهد بود.

من از این برچسب متا روبات ها در ایجاد یک صفحه تشکر استفاده کرده ام.

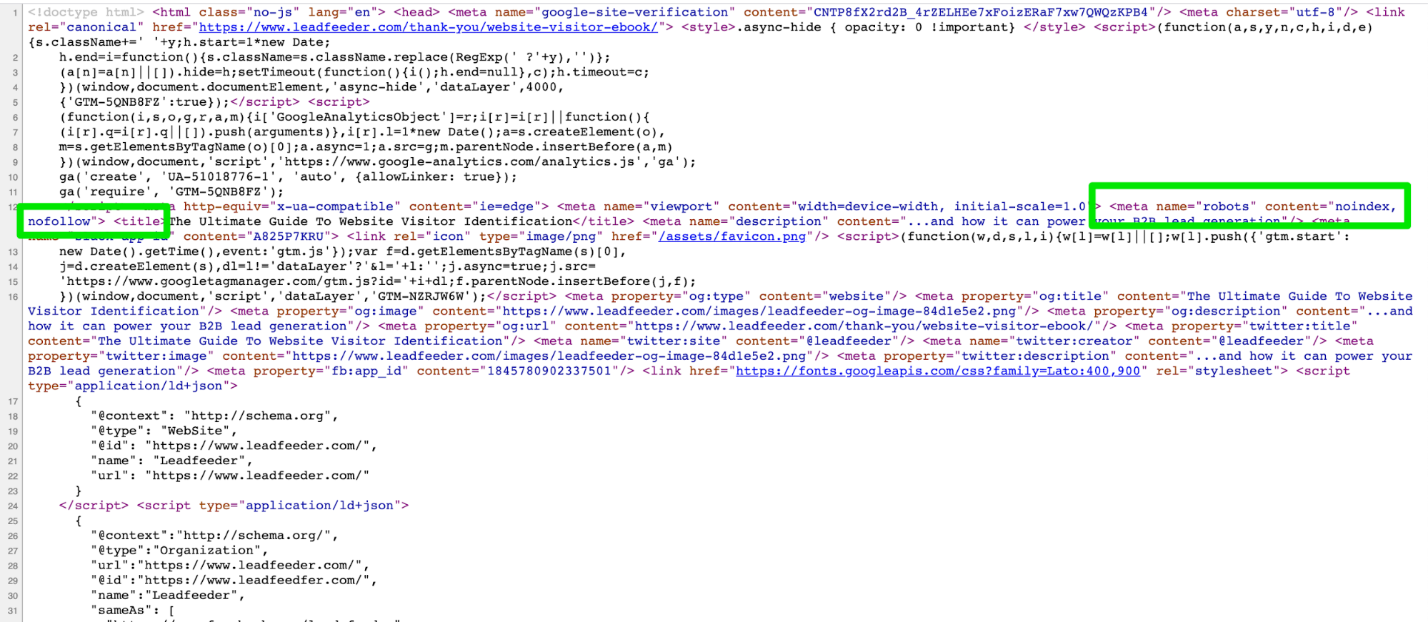

در اینجا نمونه ای از صفحه تشکر پس از دانلود کتاب الکترونیکی ارائه شده است.

حال، اگر به کد backend نگاه کنید، می بینید که noindex و nofollow را نشان می دهد.

اگر از دستورالعملهای برچسب متا روباتهای مختلف برای عوامل جستجوی کاربری مختلف استفاده میکنید، باید از برچسبهای جداگانه برای هر ربات استفاده نمایید.

به هیچ عنوان نباید برچسب های متا روبات ها را خارج از بخش < head > قرار دهید. گلن گیب (Glenn Gabe) در این مطالعه موردی (this case study.) به شما نشان می دهد که چرا باید چنین باشد.

نوع 2: برچسب ربات های ایکس

برچسب x-robots به شما امکان می دهد همان کاری را که برچسب های متا ربات ها حتی در هدرهای یک پاسخ HTTP انجام می دهند، انجام دهید.

و اساساً، عملکرد بیشتری نسبت به برچسب های متا روبات ها در اختیار شما می گذارد.

با این حال، شما به فایل های php.، htaccess. یا سرور نیاز دارید.

به عنوان مثال، اگر می خواهید یک تصویر یا ویدیو را مسدود کنید، اما نه کل صفحه را، به جای آن از x-robots-tag استفاده کنید.

پارامترهای برچسب متا روبات ها

راه های زیادی برای استفاده از دستورالعمل های برچسب متا روبات ها در کد وجود دارد. اما، ابتدا باید بدانید که این دستورالعمل ها چیست و چه کاری انجام می دهند.

در اینجا خلاصه ای از دستورالعمل های برچسب متا روبات ها ارائه شده است:

- all- بدون محدودیت برای نمایه سازی و محتوا. این دستورالعمل به طور پیش فرض استفاده می شود. هیچ تاثیری بر کارکرد موتورهای جستجو ندارد. من از آن به عنوان یک میانبر برای فهرست استفاده کرده ام.

- index – به موتورهای جستجو اجازه می دهد تا این صفحه را در نتایج جستجوی خود نمایه کنند. این یک پیش فرض است. نیازی نیست این را به صفحات خود اضافه کنید.

- noindex - صفحه را از فهرست موتورهای جستجو و نتایج جستجو حذف می کند. این بدان معنی است که جستجوگران سایت شما را پیدا نکرده و یا روی آن کلیک نمی کنند.

- follow – به موتورهای جستجو اجازه می دهد تا لینک های داخلی و خارجی را در آن صفحه دنبال کنند.

- nofollow – به لینک های داخلی و خارجی اجازه ی دنبال کردن نمی دهد. این بدان معنی است که این لینک ها از لینک های داخلی عبور نمی کنند.

- none – همانند متا برچسب های noindex و nofollow.

- noarchive - لینک "کپی ذخیره شده" را در SERP ها نشان نمی دهد.

- nosnippet – نسخه توضیحات بیشتر این صفحه را در SERP ها نشان نمی دهد.

- notranslate – ترجمه این صفحه را در SERP ارائه نمی کند.

- noimageindex – تصاویر موجود در صفحه را نمایه نمی کند.

- unavailable_after: [RFC-850 date/time] – این صفحه را پس از تاریخ/زمان مشخص شده در SERP ها نشان نمی دهد و از فرمت RFC 850 استفاده می کند.

- max-snippet - حداکثر عدد را برای تعداد کاراکترها در توضیحات متا ایجاد می کند.

- max-video-preview – تعداد ثانیه هایی که یک ویدیو پیش نمایش می کند را تعیین می نماید.

- max-image-preview – حداکثر اندازه را برای پیش نمایش تصویر تعیین می کند.

گاهی اوقات موتورهای جستجوی مختلف پارامترهای متا با برچسب متفاوتی را می پذیرند. در اینجا این تفکیک برای این مسئله ارائه شده است:

Value | Google | Bing | Yandex |

index | Yes | Yes | Yes |

noindex | Yes | Yes | Yes |

none | Yes | Doubt | Yes |

noimageindex | Yes | No | No |

follow | Yes | Doubt | Yes |

nofollow | Yes | Yes | Yes |

noarchive | Yes | Yes | Yes |

nosnippet | Yes | No | No |

notranslate | Yes | No | No |

unavailable_after | Yes | No | No |

نحوه استفاده از برچسب های متا روبات ها

اگر از یک وبسایت وردپرسی استفاده میکنید، گزینههای افزونه زیادی برای شما وجود دارد که بتوانید برچسبهای متا روباتهای خود را تنظیم کنید.

من ترجیح می دهم از Yoast استفاده کنم. این یک افزونه سئوی همه کاره در وردپرس است که قابلیت های زیادی را ارائه می دهد.

اما افزونه های دیگری چون Meta Tags Manager و GA Meta Tags نیز وجود دارد.

برای کاربران جوملا، EFSEO و Tag Meta را توصیه می کنم.

مهم نیست که سایت شما مبتنی بر چه چیزی ساخته شده است، در اینجا سه نکته برای استفاده از برچسب های متا روبات وجود دارد که عبارتند از:

- استفاده از حروف بزرگ و کوچک: موتورهای جستجو ویژگی ها، مقادیر و پارامترها را با حروف بزرگ و کوچک تشخیص می دهند. توصیه می کنم برای بهبود خوانایی کد، از حروف کوچک استفاده کنید. به علاوه، اگر شما یک بازاریاب سئو هستید، بهتر است عادت به استفاده از حروف کوچک داشته باشید.

- اجتناب از چندین برچسب : استفاده از چندین متا برچسب باعث ایجاد تضاد در کدها می شود. از چندین مقدار در برچسب خود استفاده کنید، مانند نمونه ی زیر:

meta name=“robots” content=”noindex, nofollow”>.

- از متا برچسب های متناقض برای جلوگیری از اشتباهات نمایه سازی استفاده نکنید: به عنوان مثال، اگر چندین خط کد با متا برچسب هایی مانند و دارید، تنها "nofollow" در نظر گرفته خواهد شد. دلیل آن نیز این است که ربات ها ابتدا مقادیر محدود کننده را قرار می دهند.

فعالیت برچسب های Robots.txt و Meta Robots به صورت توامان

یکی از بزرگترین اشتباهاتی که هنگام کار بر روی وب سایت های کاربران خود می بینم این است که فایل robots.txt با آنچه در برچسب های متا روبات ها بیان کرده اند مطابقت ندارد.

به عنوان مثال، فایل robots.txt صفحه را از نمایه سازی پنهان می کند، اما برچسب های متا روبات برعکس عمل می کنند.

مثالی از Leadfeeder که در بالا نشان دادم را به خاطر دارید؟

بنابراین، متوجه خواهید شد که این صفحه تشکر در فایل robots.txt و با استفاده از برچسب های متا روبات noindex، nofollow، غیر مجاز است.

در تجربه من، گوگل به مواردی که توسط فایل robots.txt ممنوع شده است، اولویت داده است.

اما، میتوانید عدم انطباق بین برچسبهای متا روبات و robots.txt را با بیان واضح به موتورهای جستجوگر حذف کنید و مشخص کنید که کدام صفحات باید نمایه شوند و کدام نشود.

سخن پایانی

اگر هنوز در حال یادآوری روزهای خرید یک فیلم بلاک باستر (Blockbuster) در یک مرکز خرید هستید، ایده استفاده از robots.txt یا متا برچسب ها همچنان ممکن است بسیار پرطرفدار به نظر برسد.

اما، اگر قبلاً « Stranger Things» را تماشا کرده اید، به آینده خوش آمدید.